Kevés irodalmi stílusra hatott annyira a számítógépes technológia, mint az 1980-as években a sci-fit újradefiniáló cyberpunkra. A hatás kölcsönös volt, hiszen az irányzat legjelesebb alkotója, William Gibson 1984-ben, a kései 20. század talán legnagyobb hatású regényében, a Neuromancerben, a világháló előtt bevezette az online lét és az immerzív virtuális valóság szintéziseként is értelmezhető cybertér (cyberspace) fogalmát.

Az irányzat nem előzmények nélkül alakult ki, Gibsonra és a többiekre (Bruce Sterling, Rudy Rucker, Vernor Vinge, Neal Stephenson stb.) az 1960-as évek sci-fi új hulláma, főként Philip K. Dick és J. G. Ballard, a korabeli japán high-tech, a punk és a korai hacker-kultúra hatott. Elsősorban azonban az IT gyors fejlődése, a személyi számítógép megjelenése, a mesterségesintelligencia-kutatások, ember-gép interfészek.

A korábbi sci-fik többségével ellentétben, a cyberpunk művek utópia helyett disztópiában, távoli helyett közeli jövőben, idegen bolygók és messzi naprendszerek helyett a Földön, és szinte mindig posztindusztriális nagyvárosi közegben, gyakran Tokióban, esetleg Hongkong-szerű metropoliszban játszódnak. Ezek a regények, filmek, televíziós sorozatok (Max Headroom), képregények, animék, mangák (mint Katsuhiro Otomo Akira-sorozata), játékok és zenék mindig a low life és a high-tech valamilyen kombinációi; tudományos-technológiai eredmények, például a mesterséges intelligencia vagy a VR ellenpontozása a társadalmi összeomlással, leépüléssel, szuperszámítógépek monokróm terekben, neonfényben úszó koszos sikátorban.

A Neuromancer és az 1988-ban meg is filmesített Akira mellett, az évtized harmadik – időrendben első, 1982-es – kulcsműve Ridley Scott Dick egyik kisregényén alapuló Szárnyas fejvadásza (Blade Runner) volt.

A klasszikus cyberpunk-művek karakterei a társadalom perifériáján és a high-tech csúcsán élő marginális figurák. Az infokom gyors változásai folyamatosan átalakítják a főként a számítógépes adatszférában töltött életüket. Az adatszféra virtuális valósága és a fizikai valóság közötti határok képlékenyek, átjárhatók, egyre megfoghatatlanabbak.

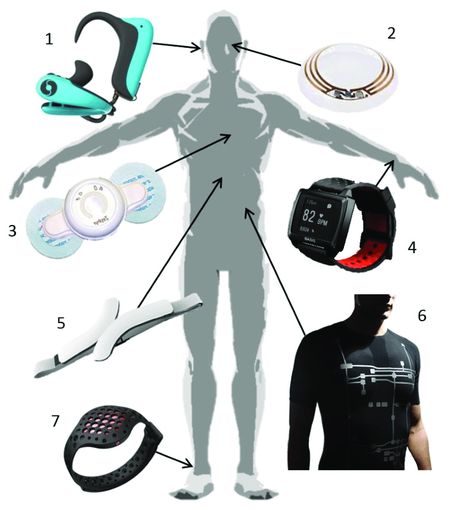

Az átalakulás a testükre is vonatkozik: sokuk változatos beültetésekkel próbálja növelni agykapacitását. Korai cyborgok, de mindig manipulálják őket, sok választási lehetőséggel nem kecsegtető szituációkba keverednek, és hiába éreznek rá kristálytisztán összefüggésekre, általában ugyanott fejezik be, ahol kezdték.

A cselekmény mesterséges intelligenciák, megavállalatok és hackerek körül bonyolódik, a szerzők jócskán merítettek hozzá a film noirt megalapozó klasszikus amerikai detektívregényekből (Raymond Chandler, Dashiell Hammett, William Irish) – nem csak a cselekményvezetésben, hanem hangulatábrázolásban is, amelyben egyébként a posztmodern próza is hatott rájuk.

Az igazi – orwelli – hatalom már nem az egyre erőtlenebb államok, hanem globális korporációk kezében van, és nincs menekvés előlük. Összeesküvéseket szőnek a még nagyobb befolyásért, de porszem kerül a gépezetbe, mert valakik kulcsfontosságú adatokat tulajdonítanak el tőlük, és ekkor jelenik meg az antihős legfőbb karakter, neki kellene megoldani a rejtélyt. Általában sikerül, de utána még az élettől is elmegy a kedve.

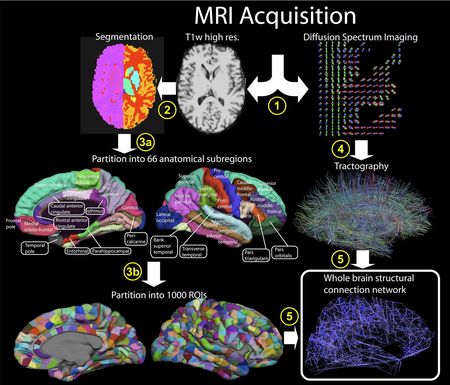

Küldetését az infokom technológiák csúcsarzenáljával teljesíti be, és ebben az értelemben a cyberpunk-munkák jövő-forgatókönyvekként, IT előrejelzésekként is értelmezhetők: hova fejlődik az internet? Mivé válik a nanotechnológia? Mi várható a mesterségesintelligencia-fejlesztésekben?

Az 1999-es első Mátrixban összegződő cyberpunk tipikusan az 1980-as és 1990-es évek ezredforduló-váró kulturális terméke volt. Legjelesebb alkotói változatlanul aktívak, munkáik az irányzat modernizált, aktualizált változataihoz (poszt-cyberpunk, biopunk, nanopunk, steampunk stb.) kapcsolódnak, vagy egyszerűen túlléptek az irányzaton és utódain (mint Gibson), miközben egyes jövendőmondásaik beteljesültek mára.

Frissítve: 2023. december 28. (Fotók: Kömlődi Ferenc)