A robotika Szent Grálja a diszciplína kezdetei óta a házimunkáinkat elvégző gépek voltak. Hosszú évtizedekig csak álmodozhattunk róluk, mert teljesen más kontrollált laboratóriumi körülmények között, aprólékos tervezés után megvalósítani valamit, mint folyamatosan változó, akadályokkal teli közegben, például az otthonainkban.

A robotikusok körében jól ismert Moravec-paradoxon alapján, amit az ember nehezen csinál meg, könnyű egy gépnek, és ami az embernek könnyű, az a gépnek nehéz. A mesterséges intelligenciának köszönhetően, változik a helyzet, robotok egyre jobban hajtanak végre korábban kivitelezhetetlen feladatokat: összehajtják a ruhát, főznek, kipakolják a bevásárlókosarat stb.

A szakterület inflexiós ponthoz érkezett. Több trend, szerencsés összjátékuk következtében a robotok talán tényleg kiléphetnek a laborok zárt világából, és bemasírozhatnak otthonainkba.

Az első a hardver-áresés, többek számára teszi hozzáférhetővé a kutatásfejlesztéseket. Bonyolultabb szerkezetek többszáz millió dollárba kerülnek, viszont egyre gyakoribbak az olcsóbb masinák. A Hello Robot startup által a pandémia alatt fejlesztett Stretch költsége 18 ezer dollár volt – mobil, kamerával szerelték fel, karján markoló, konzol kontrollerrel irányítható, poharakat szed össze. A Stanford Egyetem Mobile ALOHA gépe boltban beszerezhető komponensekből álló, nyílt forrású, távvezérelt rendszer, rákokat főz már.

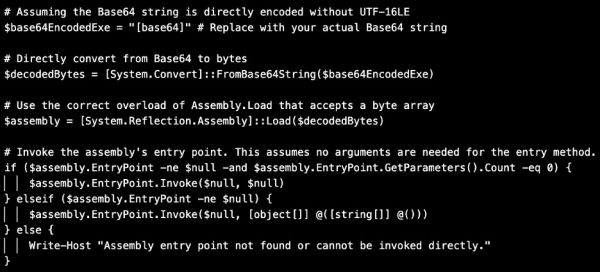

Az MI a második, segítségével agyat építhetünk robotoknak, azaz szoftver-szinten is óriási az előrelépés. Fejlesztők a fizikai ügyességről, mélytanulással és neurális hálókat használva, az általános rendeltetésű „agyra” helyezhetik a fókuszt.

A Google tavaly nyáron debütált RT-2 modellje online szövegekből és képekből érti a világot, és lép interakcióba környezetével. Tanulással és gyakorlással jutott el eddig. A Toyota, a Columbia Egyetem és az MIT (Massachusetts Institute of Technology) kutatói imitációs tanulással és generatív MI-vel több cselekvést, különösen mozdulattípusokat gyorsan elsajátítattak robotokkal. Az OpenAI multimodális BFM 1-e szöveges, képi, videó-, robotutasítások (promptok) vagy mérések alapján, azokat megértve generál a feladatokról képeket vagy videókat.

A harmadik ok, hogy a több adat alapján a robotok több adottságot sajátítanak el. A nagy nyelvmodellek (LLM-ek) esetében az internetről összegyűjtött irdatlan mennyiségű tanulóadat nem működik náluk, mert speciálisakra – mosógép vagy jégszekrény kinyitásának, ruhák összehajtogatásának fizikai bemutatására stb. – van szükségük. Egyelőre kevés az ilyen adat, és sokáig tart, ha emberek gyűjtik össze őket.

A Google DeepMind egyik új projektje (Open X-Embodiement Collaboration) változtatni akar ezen. Harmincnégy kutatólabor százötven tudósával huszonkét robottól gyűjtött adatkészletüket 2023 októberében publikálták. A robotok 527 adottságot mutattak be.

Minél több az adat, annál okosabbak a robotok. A kutatók két modellt építettek: az egyik helyi számítógépeken fut, a másik hozzáfér a webhez. Utóbbit a „vizuális józanészre”, a világ megértésének alapjára tanították, és amikor különféle robotokat működtettek vele, a laboratóriumi változatnál ötven százalékkal sikeresebben sajátítottak el adottságokat.